In Sachen Kafka könnte man Alexander Clauß schon fast einen alten Hasen nennen. Seit er im April 2018 als Consultant zu ITGAIN in Hannover wechselte, setzt er sich intensiv mit der Software auseinander. Und nicht nur darin ist er Experte. Auch in der Banken- und Versicherungsbranche kennt er sich bestens aus. Schließlich arbeitete er bereits sieben Jahre lang bei einem IT-Dienstleister der öffentlich-rechtlichen Versicherer im Norden Deutschlands. Jetzt plant er einen Workshop mit seinen ehemaligen Kollegen. So wollen sie gemeinsam herausfinden, ob es sinnvoll ist, das aktuelle Message Bus System durch Kafka zu ersetzen.

Warum wechseln?

Das Message Bus System hat bei dem IT-Dienstleister vor allem eine Aufgabe: Es soll die verschiedenen Programme der jeweiligen Versicherung verknüpfen und damit Datenänderungen zusammenzuführen. Der Beweggrund für den IT-Dienstleister, das Message Bus System auszutauschen, liegt vor allem darin, herstellerunabhängiger und handlungsfähiger zu werden und damit die IT zukunftsfähiger zu gestalten. Denn üblicherweise haben Versicherungen diverse Anwendungen im Einsatz – beispielsweise Partnersysteme, Vertragssysteme, Schadensanwendungen oder Systeme für den Außen- und Innendienst. Als zentraler Kommunikationskanal bündelt Kafka die Kommunikation zwischen diesen Systemen.

Dabei muss die Software allerdings absolut transaktionssicher sein. Das heißt, Aktionen müssen entweder ganz oder gar nicht ausgeführt werden – und das nacheinander. So soll verhindert werden, dass Prozesse, die sich gegenseitig ausschließen, parallel ablaufen können. Mit einer Transaktion sind alle schriftlichen Änderungen im System gemeint, etwa Namensänderungen, Vertragsanpassungen, Neuabschlüsse oder Kündigungen.

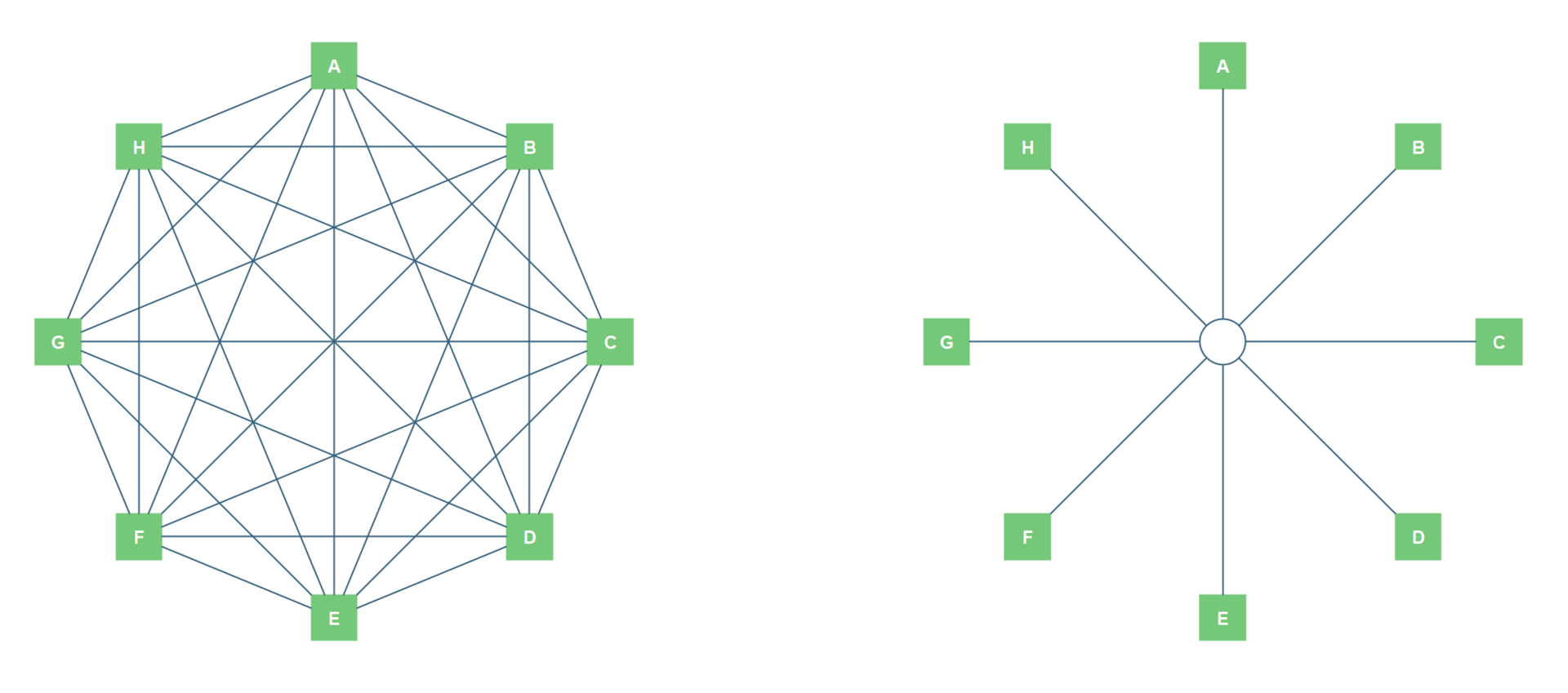

Links: Die Netzwerkteilnehmer sind direkt miteinander verbunden. Mit jedem neuen Teilnehmer steigt die Anzahl der Verbindungen im Netzwerk exponentiell.

Rechts: Als zentraler Kommunikationskanal bündelt das Message-Queue-System die Kommunikation zwischen den Teilnehmern. Die Skalierung der Verbindungen ist wesentlich effizienter.